【ざっくり紹介】WWDCで発表されたApple Intelligenceとは?

2024年6月10日のApple WWDCにおけるKeynote「WWDC 2024 — June 10 | Apple」でさまざまな機能が発表された。その中で、特に注目されたApple Intelligenceについて、ざっくりと内容をサマリーし、ご紹介する。

どんな人におすすめの記事なのか?

- WWDCで発表されたApple Intelligenceの概要をクイックに把握したい

この記事を読むと学べること

- Apple Intelligenceの概要について

Apple Intelligenceとは?

Apple IntelligenceはWWDCで発表されたパーソナルインテリジェンスシステムで、iPhone、iPad、そしてMacのコアとして生成モデルが組み込まれている。そのApple Intelligenceは、今年の夏にUS英語で試用できるようになり、今秋、iOS 18、iPadOS 18、macOS Sequoiaの一部としてベータ版でユーザーに提供され、来年中にいくつかの機能、追加の言語、プラットフォームがリリースされる予定である。

機能(Capabilities)

言語(Languages)

Apple Intelligenceには大規模な言語モデルが組み込まれており、深い自然言語理解を可能とし、日常生活や仕事などにおける多くのタスクを迅速に、そして簡単に処理してくれる。

画像(Images)

写真、絵文字、GIFなどオリジナルの画像を生成することができる。

「友達の誕生日を祝うときは、ケーキ、風船、花に囲まれた画像を作成して、さらにお祝いにすることができます。そして、次にお母さんに彼女があなたのヒーローだと言ったら、スーパーヒーローのマントを着た彼女の画像を送って、あなたの主張を本当に的確にすることができます。メッセージに加えて、このエクスペリエンスは、メモ、フリーフォーム、キーノート、ページなど、システム全体のアプリに組み込まれています。」と紹介している。

アクション(Action)

Apple Intelligenceは、デバイスに入っているあらゆるアプリケーションを横断し、数多くのアクションを実行することができる。

個人情報とコンテキスト(Personal Context)

個人情報とコンテキストに基づいており、アプリケーション全体から最も関連性の高いデータを取得し分析したり、表示しているメールやカレンダーのイベント情報などの画面上のコンテンツを参照したりできる。「会議の 1 つが午後遅くに予定変更され、娘の演劇に時間通りに行けなくなるのではないかと考えているとします。Apple Intelligenceは、私を支援するために関連する個人データを処理することができます。娘が誰であるか、数日前に娘が送った演劇の詳細、会議の時間と場所、オフィスと劇場の間の予測トラフィックなどを把握できます。」と紹介。

ここで個人情報の取り扱いについて気になるが、Appleはこの後のアーキテクチャーに関する説明で触れている。

アーキテクチャー(Architecture)

On-device processing

Apple Intelligenceは基本的にデバイス上で処理されるように設計されている。深く統合された生成モデルには膨大な処理能力が必要となるが、最先端のApple Silicon、A17 Pro、Mファミリーのチップがオンデバイスでの処理を可能とするとのこと。リクエストを行うと、Apple Intelligenceはセマンティックインデックスを使用して関連する個人データを識別し、それを生成モデルにフィードし、最適なサポートとなるパーソナルコンテキストを提供する。これらのモデルの多くは、完全に オンデバイスで実行される。

Private Cloud Compute

より大規模な処理にはサーバーが必要になることがある。一般的に従来よりサーバーは気付かないうちにデータを保存し、意図しない方法で使用することもできた。そこで、iPhoneなどのデバイスにおけるセキュリティとプライバシーへの取り組みをクラウド環境化へも拡張し、多くのインテリジェンスを解き放ちたいという思いからPrivate Cloud Computeの開発に至った。Private Cloud Computeにより、プライバシーを保護しながら、その計算能力を柔軟かつ拡張し、より複雑なリクエストに対してさらに大規模なサーバーベースのモデルを利用することができるようになる。(※これらのモデルは、Apple Siliconを使用して構築したサーバー上で実行される。)

ユーザー体験(Experiences)

Siri

会話のコンテキストを理解し、より自然な会話でコミュニケーションを行うことが可能となる。また、音声のみならずSiriにテキストを入力してコミュニケーションをとることもできるようになる。Siriは、機能や設定などに関する大量の情報を保有しているため、iPhoneなどの使用したい機能などについて、その機能が何か分からなくても、そのコンテキストを汲み取って、質問を返してくれるようになる。

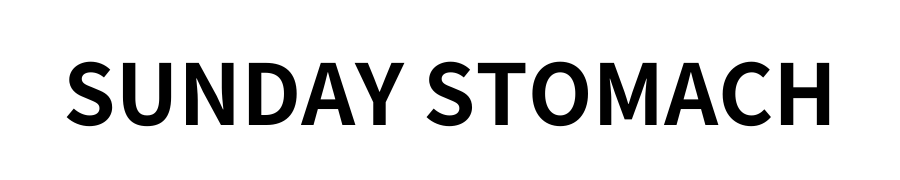

Writing Tool

文章の書き直しや校正が簡単にできるようになる。

メール機能

文面の質問を識別し、回答を素早く選択できるような機能も登場する。例えば、イベントの出欠メールが届いた場面を思い浮かべてほしい。Apple Intelligenceが質問を識別して、画面上にタップ操作で回答ができる選択肢を提供してくれる。

また、メールの最初の行は「お世話になっております」などから始まる定型文だったりで、メール一覧のプレビューでは内容を理解できないことも多いが、メールの文面を識別して、そのメールの概要を表示することも可能になる。

さらに、優先度の高いメッセージを緊急性が高いと判断して受信メールのトップに表示してくれる便利な機能も実装される。

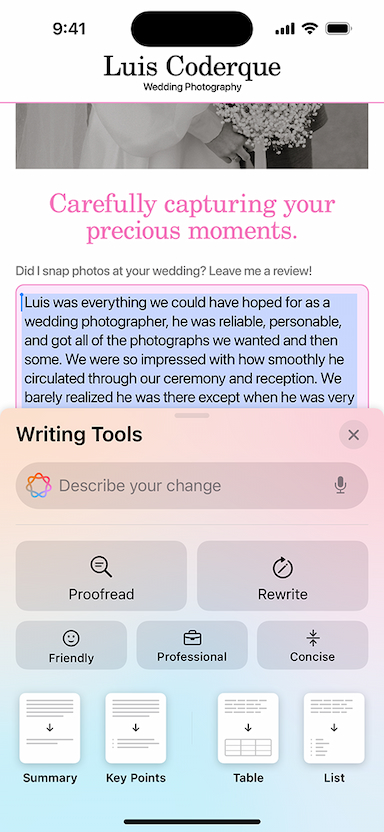

Genmoji

説明を入力するだけで、Genmojiを作成することができる。また、メッセージしている相手をフォトライブラリーで認識しているため、すぐにその人そっくりのGenmojiを作成し、共有したりすることも可能だ。

Image Playground

遊び心のある画像をわずか数秒で作成できる。

Image Wand

ラフスケッチを洗練された画像に変換して、メモを補完し、より視覚的にすることができる。周囲の単語を分析し、その要素を入れた形で画像を作成できるのだが、空白のスペースを丸で囲んでその周囲のコンテキストを分析して、ゼロから画像を生成することもできる。ラフ画さえいらないみたいだ。

画像編集(Cleanup Tool)

被写体の背景に写る不要なオブジェクトを識別し、消すことができる。これはGoogle PixelのCMでよく見るものに似ている機能だが、あると便利なのは間違いない。

ChatGPT

ChatGPT-4oモデルがアカウントを作成することなく、利用できるようになる。さらに情報は記録されないとのこと。有償版のChatGPTを利用している場合、そのアカウントと連携して、有料機能に直接アクセスできるようになるみたいである。(※Chat GPT の統合は、iOS 18、iPadOS 18、macOS Sequoia に今年後半に導入される予定)このChatGPTはSiriに組み込まれる。

Xcode

Swift と SwiftUI を使用してアプリを開発するために、Xcode にジェネレーティブインテリジェンスを導入し、オンデバイスコード補完やSwift コーディングの質問に対するスマートアシスタンスなどの機能が実装される。

まとめ

Apple Intelligenceは、われわれの日常生活や仕事の中で生じるタスクや無駄な時間を削減し、よりクリエイティブな体験を提供する。

- Siri:言語処理が進化し、より自然な会話でのコミュニケーションが可能に

- Writing Tool:文章の校正と書き直しを支援

- メール機能:優先度の高いメールやメールの概要をプレビュー表示

- Genmoji:Genmoji作成

- Image Playground:画像生成

- Image Wand:画像生成(ラフ画を周りのコンテキストを分析し、画像生成)

- 画像編集(Cleanup Tool):背景の無駄なオブジェクトを消してくれる

- ChatGPT:Open AIのChatGPTと連携。まずはSiriから。

- Xcode:wift コーディングの質問に対するスマートアシスタンスなど